研究者有志〝慣行〟白日に

地球温暖化問題を議論するとき、普通の人々は、モデル計算による温度上昇のシミュレーションを科学計算に基づく予測だと思って受け入れている。だが実は、シミュレーションは物理学や化学の基礎方程式をそのまま直接に解いたものではない。モデルには任意性のあるパラメーターが多数設定されており、二酸化炭素(CO2)等の濃度上昇に対して地球温暖化がどの程度になるか、結果を見ながらチューニング(調整)されている。このことはあまり公の場で語られてこなかったが、近年になって、一部の有力な研究者が公表するようになった。

モデルに多くの数値設定

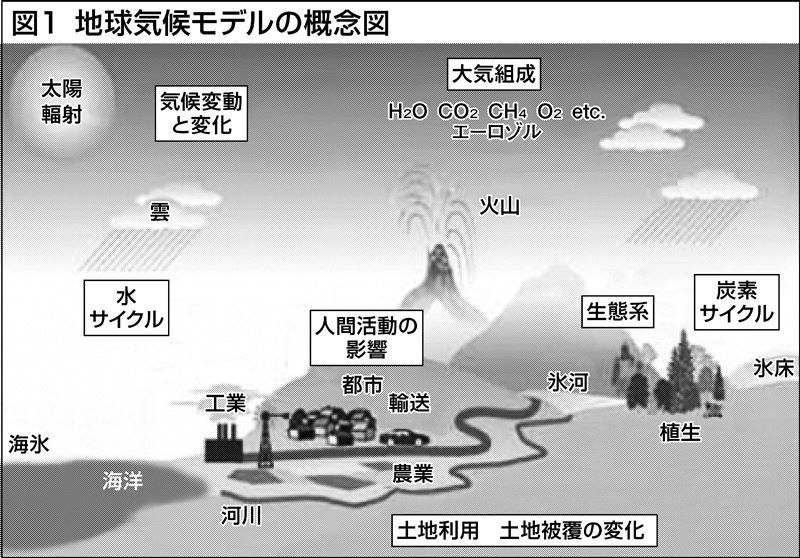

地球気候モデル(GCM)とは、コンピューターを使って地球気候システムのシミュレーションをするものだ(図1)。GCMには大気、海洋、地表、海氷、氷床をモデル化したモジュールがある。

大気モジュールは風、温度、湿度、大気圧の推移を計算する。GCMにはまた、海洋の水循環、それが熱をどう運ぶか、海洋が大気と熱や湿気をどうやりとりするかを表す数式もある。地表モジュールは、植生、土壌、雪や氷による被覆が大気とエネルギーや湿度をどうやりとりするかを記述する。海氷や氷床のモジュールもある。

モデルの数式の一部は、ニュートンの運動法則や熱力学第一法則といった物理法則に基づいているが、主要プロセスの中には、物理法則に基づかない近似もある。

コンピューターでこうした方程式を解くため、GCMは大気、海洋、陸地を3次元のグリッドに切り分ける。そしてグリッドのそれぞれのセルごとに方程式が計算される。これがシミュレーション期間の時間ステップについて繰り返される。グリッドとセルの数が、モデルの解像度を決める。GCMで一般的な解像度は、水平方向25キロ ― 300キロメートル、垂直方向は1キロメートル、時間ステップは30分ごとであるが、これは年々高くなっている。

とはいえ、モデルの空間的・時間的解像度は現実の気候系と比べるとかなり粗い。そして、重要なプロセス(例=雲の形成や降雨の発生)はモデルの解像度より小さい規模で起こる。こうしたグリッドのサイズ以下の物理的・化学的なプロセスは、実際のプロセスを近似しようとする割と簡単な数式で表現される。それは実測に基づいたり、もっと詳細なプロセスモデルから導かれたりする。

そこでは多くのパラメーターが設定される。そして、そのパラメーターは、過去の観測値と気候モデルの出力を近づけるために「チューニング」される。

GCMで使われる数式は、気候系における物理的・化学的プロセスの近似でしかなく、こうした近似の一部はどうしても粗雑になる。この理由は、プロセスが科学的によく分かっていなかったり、観測データが不足していたり、コンピューターの計算能力に限界があったりするためだ。

20世紀後半の再現、暗黙のルールに

モデルのチューニングについて、研究者はあまり公の場で語ってこなかった。だが近年になって、この業界の有力な研究機関の研究者たちが、その実態について発表するようになってきた。

2016年、米科学誌サイエンスに「気候科学者、ブラックボックスを開いて検討にかける」という記事が掲載された。ドイツのマックス・プランク研究所、米国の地球物理流体力学研究所など、気候モデル業界において最も有力な研究機関の研究者たちの情報提供に基づくもので、概要は以下の通りだ。

- 「チューニング」という慣行が気候モデル業界に存在する

- モデル研究者はチューニングをできるだけ少数のパラメーターの調節に制限しようと努力するが、思うように減らすことはまずできない

- チューニングは科学でもあるが、職人技(ART)でもある。「それは、音の悪い楽器を調整するようなものである」

- 「すべてのモデルがチューニングされている」

研究者が認めるか否かにかかわらず、ほぼすべてのモデルは20世紀後半の地球温暖化を再現するようにチューニングされている。

チューニングについて語ることは長い間タブーだった。それは、本当のことを語ると「人為的温暖化説に懐疑的な人々に付け込まれる」との恐れによるものだった。しかし一部の研究者たちは、チューニングをどのように行ったのか、その手続きを公開することが適切と考えた。理由は三つで

- 透明性を高めることはモデルの改善に役に立つ

- 環境影響の研究者にとって、モデルの出力結果がプロセスの計算によるものなのかチューニングのせいなのかを知ることは大事である

- モデルの結果は政策決定に利用されるから、チューニングの実態を明らかにしたほうがよい

といったことだ。

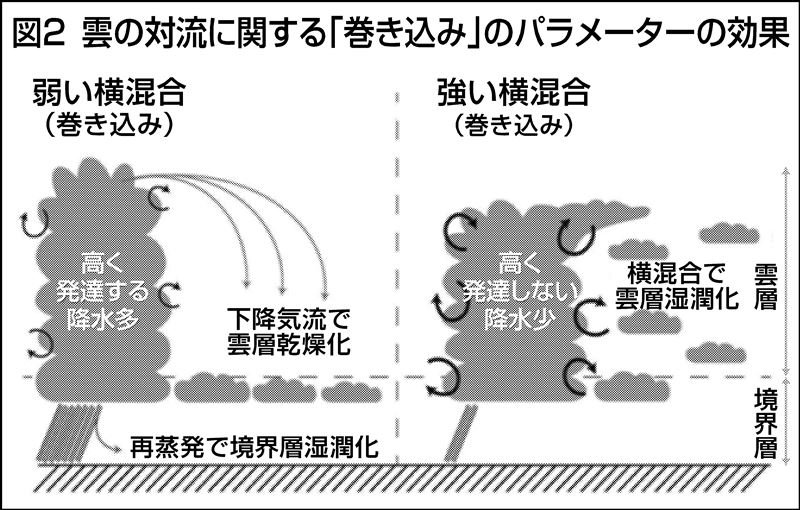

チューニングの実態について最も顕著な例を紹介しよう。マックス・プランク研究所のモデルには、雲の対流に関する「巻き込み」のパラメーターがあった(図2)。このパラメーターの設定次第で、周囲から空気を巻き込まず雲が高く発達する(図2左)か、周囲から空気を巻き込むので雲が発達しない(同右)か、いずれかのモデルになる。このパラメーターは理論や観測で十分に範囲を絞ることができず、設定に任意性があるものだった。

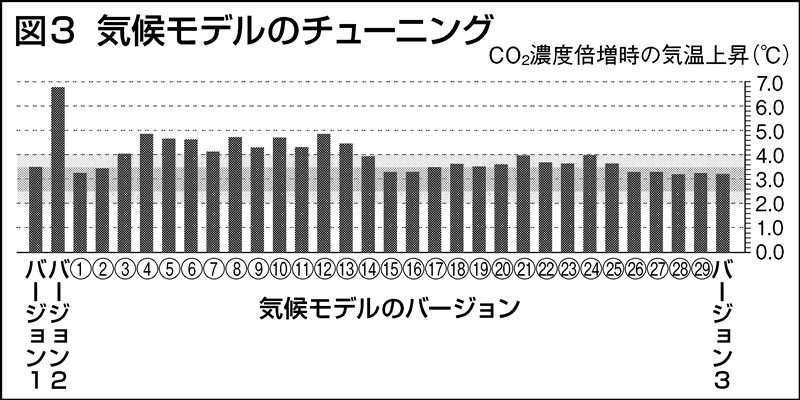

このグループは、以前の論文では気候感度(=CO2濃度が産業革命前の280ppmから560ppmに倍増した場合の平衡状態における地球平均の温度上昇。気候モデルのCO2濃度に対する感度を特徴づける指標としてよく使用される)が3.5℃としていた(図3のバージョン1)。

ところが、その後、モデルにおける別のプロセスを改善したところ、気候感度がそれまでの3.5℃から7.0℃近くに倍増してしまった(図3のバージョン2)。そこでどうしたかというと、前述の雲の対流のパラメーターを「チューニング」して値を10倍にして、気候感度を3℃近くに下げた(図3の(1))。他にもさまさまなパラメーターを調整して多くのバージョンのモデルを作り、最終的に図3のバージョン3が次の論文として発表された。この過程では、気候感度を3℃前後にすることをはっきりと目標にしてチューニングを行った、という。

温室ガスの影響、再検証を

気候変動に関する政府間パネル報告(IPCC)では、20世紀後半に観測された地球の平均気温上昇と、モデルが示す温室効果ガス(GHG)による温度上昇が一致した、としている。このことは、地球温暖化の原因がGHGであることの証拠として紹介される。

しかしこれだけでは、観測された気温の上昇の原因がGHGによるものだという証拠には、論理的に言ってならない。というのは、モデルは、温度上昇がGHGによるものだとチューニングによって教え込まれているだけの可能性があるからである。

実際のところ、20世紀後半に起きた地球の平均気温上昇は、GHG以外の自然変動(エルニーニョのような海洋や大気の自律的振動、太陽活動の変化)による影響が大きかったのかもしれない。そうすると、それにチューニングしたモデルではGHGによる温暖化の効果は過大評価されていたのかもしれない。

このようにチューニングされたモデルの計算結果をどう解釈するか。チューニングは、科学的理解や観測データの欠如も多いとはいえ、膨大な観測データに整合するようモデルが構築された結果だと解釈すれば、その予測についても現状で入手できるデータに基づき最善を尽くした予測だ、と論じることもできよう。

しかしその一方で、最も重要な指標である気候感度(これは21世紀の気温上昇予測に決定的に影響する)がチューニングの主な対象になっていて、しかもその数値がチューニングに大きく依存して決定されることには、大いに注意が必要だ。

それに、過去についていくら合わせたところで、将来についての予測が当たる保証にはならない。統計学的に「過学習」に陥ってしまっている可能性がある。

米国の科学者スティーブン・クーニンは、チューニングに基づく予測は、捏造である、と批判している。そこまで言わずとも、政策決定に使われることを知りながら、チューニングの実態をつまびらかにすることなくシミュレーションの予測結果を発表することは、科学と政治の関係として適切とは言い難い。科学者はチューニングの実態をもっとよく説明すべきであるし、政策決定はチューニングの実態をよく理解した上で行うべきである。